Para o trb da teoria X.

Erupção colossal pode ser a primeira evidência de que energia pode ser extraída de buracos negros

concepção popular diz que nada pode escapar de um buraco negro. Uma vez que algo passa pelo horizonte de eventos – o chamado ponto de não retorno – ele fica lá, para sempre, limitado por um campo gravitacional que nem mesmo a luz consegue escapar

Mas um buraco negro em rotação gera grande quantidade de energia que, teoricamente, pode ser extraída da ergosfera, uma região que fica colada com o horizonte de eventos. Isso foi demonstrado tanto de forma teórica quanto experimentalmente – e agora uma equipe de astrofísicos encontrou o que eles acreditam ser uma evidência observacional para isso.

A prova cabal é a erupção de raios gama mais poderosa que já detectamos, GRB 190114C, uma erupção colossal com um pulso de cerca de um trilhão de elétron-volts (1 TeV), a 4,5 bilhões de anos-luz de distância.

“Erupções de raios gama, os objetos transitórios mais poderosos no céu, liberam energias de até 1054 erg em apenas alguns segundos”, disse o astrofísico Remo Ruffini do Centro Internacional para Rede de Astrofísica Relativística (ICRANet), com sede na Itália.

“Sua luminosidade nos raios gama, no intervalo de tempo do evento, é tão grande quanto a luminosidade de todas as estrelas do Universo observável! Nós vínhamos pensando que as erupções de raios gama eram alimentadas por um até agora mecanismo desconhecido de buracos negros de massa estelar

NO ano passado, Ruffini e seus colegas descobriram uma solução para esse mecanismo – um processo que eles chamaram de hipernova orientada por uma sistema binário.

Ele começa com um sistema binário próximo que consiste em uma estrela de carbono-oxigênio no final de sua vida e uma estrela de nêutrons. Quando a estrela de carbono-oxigênio se transforma em supernova, o material ejetado pode ser rapidamente sugado pela estrela de nêutrons companheira. Assim, essa companheira passa do ponto de massa crítica e colapsa em um buraco negro, que lança uma erupção de raios gama, bem como jatos de material de seus polos quase à velocidade da luz.

(O núcleo da estrela de carbono-oxigênio colapsa em uma segunda estrela de nêutrons, resultando em um sistema binário de buraco negro-estrela de nêutrons.)

Agora, em um novo estudo, Ruffini e seus colegas em uma equipe liderada por Rahim Moradi do ICRANet descreveram o mecanismo que pode lançar uma erupção de raios gama de alta energia: a aceleração de partículas ao longo de linhas de campo magnético herdadas da estrela de nêutrons-mãe do buraco negro. Esse campo magnético extrai energia rotacional da ergosfera do buraco negro.

“O novo motor apresentado na nova publicação”, explicou Ruffini, “faz o trabalho por meio de um processo puramente relativístico geral e gravito-eletrodinâmico: um buraco negro em rotação, interagindo com um campo magnético circundante, cria um campo elétrico que acelera os elétrons do ambiente para energias ultra-altas levando a radiação de alta energia e raios cósmicos de energia ultra-alta

Jatos relativísticos, ou jatos próximos à velocidade da luz, não são incomuns em núcleos galácticos ativos – os monstruosos buracos negros supermassivos no centro das galáxias. Acredita-se que esses jatos se formem a partir do processo de acreção, que ocorre da seguinte maneira.

Um enorme disco de material gira em torno do buraco negro ativo, caindo nele a partir da borda interna, mas nem todo esse material cai no buraco negro. Parte dele, acreditam os astrônomos, é canalizado e acelerado ao longo das linhas do campo magnético ao redor do buraco negro até os polos, onde é lançado no espaço na forma de jatos colimados.

Sabemos que buracos negros e estrelas de nêutrons podem ter campos magnéticos poderosos, e as evidências sugerem que estes podem atuar como um síncrotron (um tipo de acelerador de partículas). As evidências também sugerem que um síncrotron de campo magnético desempenha um papel no lançamento de uma erupção de raios gama durante a formação de um buraco negro.

Estudando GRB 190114C, Moradi e sua equipe encontraram um mecanismo semelhante – mas, em vez de um processo de emissão contínua, é discreto, repetindo-se continuamente, liberando a cada vez um quantum de energia do buraco negro para produzir a emissão de raios gama observada após a erupção de raios gama.

O Princípio da Incerteza, primeiro introduzido pelo Físico Werner Heisenberg no final da década de 1920, é um conceito fundamental da Teoria Quântica. No mundo quântico, governado por partículas subatômicas, estas se comportam também como ondas. Como resultado dessa natureza ondulatória, partículas elementares - como elétrons - não podem ter bem definidos posição e momento simultaneamente. Agora, um time internacional de pesquisadores, liderados pela cientista Dra. Mika Sillanpää da Universidade de Aalto, na Finlândia, mostrou - em um estudo publicado na Science (1) - que existe uma forma de driblar o Princípio da Incerteza, usando inclusive objetos macroscópicos se comportando como partículas subatômicas.

introduzido por Werner Heisenberg no final dos anos 1920, é um conceito fundamental da mecânica quântica.

As partículas fundamentais, como os elétrons que alimentam todos os produtos eletrônicos, também podem se comportar como ondas, o que implica que as partículas não podem ter uma posição e um momento bem definidos simultaneamente. Por exemplo, medir o momento de uma partícula leva a uma perturbação da sua posição e, portanto, a posição não pode ser definida com precisão. Este é o famoso Princípio da Incerteza de Heisenberg.

Mas Laure de Lepinay e seus colegas da Universidade Aalto, na Finlândia, demonstraram que existe uma maneira de contornar esse princípio da incerteza.

Em vez de partículas elementares, a equipe realizou os experimentos usando objetos muito maiores: Duas membranas vibratórias com um quinto do diâmetro de um fio de cabelo humano. Contudo, mesmo sendo muito maiores dos que as partículas fundamentais, as membranas foram cuidadosamente forçadas a se comportar seguindo as regras da mecânica quântica.

"Em nosso trabalho, as membranas apresentam um movimento quântico coletivo. Os tambores vibram em fases opostas entre si, de modo que, quando um deles está na posição final do ciclo de vibração, o outro está na posição oposta ao mesmo tempo. Nessa situação, a incerteza quântica do movimento dos tambores é cancelada se os dois tambores forem tratados como uma entidade mecânica quântica," explicou Lepinay.

Esse tratamento de um sistema mais complexo como sendo uma única entidade que obedece à mecânica quântica é bastante similar à usada em outro feito recente, quando físicos demonstraram que não é possível dar muitas garantias sobre o seu passado e o seu futuro.

Gravidade quântica e rede quântica

O novo experimento significa que é possível medir simultaneamente a posição e o momento dos dois tambores, o que não deveria ser possível de acordo com o princípio da incerteza de Heisenberg.

Ao quebrar a regra, a equipe conseguiu caracterizar forças extremamente fracas que acionam os tambores, aumentando o nível de precisão que era possível alcançar anteriormente.

"Um dos tambores responde a todas as forças do outro tambor de forma oposta, meio que com uma massa negativa," comparou o professor Mika Sillanpaa.

Além disso, os pesquisadores também exploraram esse resultado para fornecer as evidências mais sólidas até hoje de que esses objetos grandes podem apresentar o fenômeno do entrelaçamento quântico (ou emaranhamento).

Objetos entrelaçados não podem ser descritos independentemente uns dos outros, embora possam ter uma separação espacial arbitrariamente grande. O entrelaçamento permite que pares de objetos se comportem de maneiras que contradizem a física clássica, o que é o recurso-chave por trás das emergentes tecnologias quânticas.

A equipe afirmou que pretende usar essa técnica em testes de laboratório com o objetivo de investigar a interação da mecânica quântica e da gravidade. As membranas vibratórias também podem servir como interfaces para conectar nós de redes quânticas distribuídas em grande escala.

alimento é nosso combustível, mas mesmo sendo responsável por nos manter de pé, algumas variedades podem ser perigosas e causar doenças no cérebro. Se certas comidas podem estimular a função cognitiva e melhorar a memória, como é o caso do peixe, que contém ômega 3, outros alimentos são conhecidos pelo efeito devastador que causam ao funcionamento cerebral. Os nutricionistas até aconselham consumi-los com moderação, a fim de minimizar os impactos negativos e evitar as doenças do cérebro.

para te dar aquela força, listamos abaixo dez alimentos dos quais você deve fujir para se evitar doenças do cérebro e que podem ser bem prejudiciais ao seu organismo. Desse modo, fica mais fácil de você cuidar do seu cérebro. Fique atento:

Produtos açucarados

Além de te fazerem ganhar peso, eles podem prejudicar bastante o cérebro. O consumo em longo prazo de açúcar pode criar uma grande variedade de problemas neurológicos, interferir na memória e prejudicar a capacidade de aprendizado. Por isso, é recomendável que se evite produtos muito açucarados e com alto teor de frutose.

Conhecido por prejudicar o fígado a longo prazo, o álcool costuma criar uma espécie de “nevoeiro” cerebral – um sentimento de confusão mental que impacta a capacidade de pensar com clareza e a memória. Você já percebeu que depois de beber um pouquinho a mais é difícil lembrar nomes de itens comuns, do lugar em que estivemos ou da roupa que estávamos usando? Isso acontece por influência da grande quantidade de álcool que foi ingerida e que acabou impactando o balanceamento do cérebro. Felizmente, esses sintomas podem ser revertidos se você parar de ingerir bebida alcoólica ou se você se limitar a um ou dois drinques por semana.

Junk Food

Um estudo recente realizado pela Universidade de Montreal revelou que a junk food (comum em restaurantes fast food) pode mudar os químicos presentes no cérebro, levando a sintomas associados à depressão e à ansiedade. Além disso, os alimentos ricos em gordura também podem desencadear sintomas similares aos sinais de abstinência, quando você para de consumi-los. Esses alimentos afetam a produção de dopamina, que é uma substância química responsável pela sensação de felicidade e que dá suporte à função cognitiva do cérebro, à capacidade de aprendizado, à atenção, à motivação e à memória.

Frituras

Praticamente todas as frituras contêm químicos, corantes, aditivos, sabores artificiais e conservantes, que podem afetar o comportamento e funcionamento cognitivo do cérebro, causando doenças. Isso se dá por conta de químicos que provocam a hiperatividade, tanto em crianças, como em adultos. As frituras também destroem lentamente as células nervosas localizadas no cérebro.

Alimentos pré-cozidos

Esses alimentos podem causar doenças do cérebro porque impactam o sistema nervoso central e aumentam o risco de desenvolvimento de distúrbios degenerativos no cérebro, como o mal de Alzheimer, pois contêm muitos conservantes.

Alimentos muito salgados

Todo mundo sabe que comidas salgadas afetam a pressão sanguínea e o coração a longo prazo. Entretanto, pesquisas sugerem que essas comidas contêm quantidades elevadas de sal (sódio), que pode afetar a função cognitiva e prejudicar a capacidade de pensar. Além disso, o consumo de sal e de nicotina, por exemplo, tem os mesmos efeitos das drogas, que causam crises de abstinência quando não são mais consumidas pela pessoa.

Proteínas processadas

As proteínas são muito importantes para os músculos e para o funcionamento do corpo. A carne é a maior fonte de proteínas, mas as processadas, como salsichas e salames, devem ser evitadas. As proteínas naturais ajudam o corpo a isolar o sistema nervoso, enquanto as processadas fazem exatamente o contrário. Opte por alimentos bons para o cérebro, como peixe, laticínios, nozes e sementes, que são fontes de proteínas naturais e de alta qualidade.

Evite gordura trans a todo custo

Ela pode causar uma série de problemas, desde os relacionados ao coração até colesterol elevado e obesidade. Além disso, pode fazer mal ao seu cérebro, deixando-o mais lento e afetando os reflexos e a qualidade de resposta, sem contar o risco de AVC. E se for consumida a longo prazo, a gordura trans pode resultar em uma espécie de encolhimento do cérebro, que é um pouco semelhante com o envelhecimento causado pela doença de Alzheimer. Isso acontece porque as gorduras trans vão lentamente danificando as artérias cerebrais. Você pode evitar essa doença do cérebro e diminuir os riscos simplesmente limitando a ingestão de gorduras trans.

Adoçantes artificiais

Quando alguém está tentando perder peso, substitui o açúcar pelo adoçante artificial. Dá resultado porque os adoçantes contêm menos calorias, mas eles podem fazer mais mal do que bem. E se forem usados por um longo período de tempo, podem causar danos ao cérebro e interferir na capacidade cognitiva. Conheça “Seis opções de adoçante natural sem edulcorante sintético“.

Nicotina

Apesar da nicotina não ser de fato um produto alimentar, ela é ingerida com o cigarro e causa estragos e doenças do cérebro, restringindo o fluxo de sangue deste importante órgão, juntamente com o fluxo regular de glicose e oxigênio. A nicotina não só causa envelhecimento precoce, má respiração e representa um risco para o pulmão, como também afeta a produção e função dos neurotransmissores, apertando os vasos capilares, que são pequenos vasos sanguíneos que desempenham um papel fundamental no que se refere à função cerebral.fitnec

O cérebro é o órgão mais importante do seu corpo. Ele mantém o coração batendo, os pulmões respirando e todos os outros sistemas funcionando.

+ O que são alimentos funcionais e como eles são aliados da nossa saúde

+ 15 alimentos que aumentam a imunidade

+ Como impulsionar a capacidade do cérebro com exercícios

Por isso, uma dieta saudável é necessária para manter o seu cérebro funcionando em ótimas condições.

No entanto, alguns alimentos têm efeitos negativos neste complexo órgão e podem afetar a memória, humor, além de aumentar o risco de desenvolver demência.

Estimativas divulgadas pelo site Healthline preveem que a demência afetará mais de 65 milhões de pessoas em todo o mundo até 2030.

Para ajudar a reduzir o risco desta e de outras doenças, separamos os 7 piores tipos de alimentos para o seu cérebro.

Bebidas açucaradas

Uma pesquisa publicada pela associação Alzheimer’s & Dementia mostrou que pessoas que consomem bebidas açucaradas frequentemente, como refrigerantes e sucos de frutas, têm mais chance de adquirir problemas de memória.

Os pesquisadores também descobriram que as pessoas que bebem esses produtos diariamente estão três vezes mais propensas a desenvolver AVC (Acidente Vascular Cerebral) e demência.

Além de expandir a cintura, a alta ingestão de bebidas açucaradas também aumenta o risco de diabetes tipo 2 e doenças cardíacas.

Algumas alternativas às bebidas açucaradas incluem água, chá gelado sem açúcar, suco de vegetais e laticínios sem açúcar.

Carboidratos simples

Os carboidratos simples incluem açúcares e grãos altamente processados, como arroz branco, bolachas, pães e outros alimentos produzidos com farinha branca.

Esses tipos de carboidratos geralmente têm um alto índice glicêmico. Isso significa que o seu corpo os digere rapidamente, causando um aumento nos níveis de açúcar no sangue e de insulina.

Além disso, quando consumidos em grandes quantidades, esses alimentos costumam ter uma alta carga glicêmica. Alimentos deste tipo podem prejudicar a memória de crianças e adultos.

Os carboidratos também podem ter outros efeitos no cérebro. Por exemplo, um estudo descobriu que crianças de 6 a 7 anos que consumiam dietas ricas em carboidratos refinados também tiveram pontuação mais baixa em inteligência não verbal.

Carboidratos saudáveis de baixo índice glicêmico incluem alimentos como vegetais, frutas, legumes e grãos inteiros.

Alimentos ricos em gordura trans

A gordura trans é o nome dado à gordura vegetal que passa por um processo de hidrogenação natural ou industrial – e que pode ter um efeito prejudicial na saúde do seu cérebro.

Embora as gorduras trans ocorram naturalmente em produtos de origem animal, como carnes e laticínios, essas não são a grande preocupação. São as gorduras trans produzidas industrialmente que tornaram-se um problema.

Essas gorduras trans artificiais podem ser encontradas em margarina, salgadinhos, bolos prontos e biscoitos pré-embalados.

Estudos descobriram que quando as pessoas consomem maiores quantidades de gorduras trans, elas tendem a ter um risco maior de desenvolver doença de Alzheimer, memória fraca, menor volume cerebral e declínio cognitivo.

No entanto, alguns estudos não encontraram uma associação entre a ingestão de gordura trans e a saúde do cérebro. Mas elas devem ser evitadas, pois há evidências de que elas têm um efeito negativo em muitos outros aspectos da saúde, incluindo a saúde do coração e inflamação.

Dietas ricas em ômega-3 ajudam a proteger contra o declínio cognitivo. Os ômega-3 aumentam a secreção de compostos antiinflamatórios no cérebro e podem ter um efeito protetor, especialmente em adultos mais velhos.

Você pode aumentar a quantidade de gorduras ômega-3 incluindo em sua dieta alimentos como peixes, sementes de chia, sementes de linho e nozes.

Alimentos altamente processados

Alimentos altamente processados tendem a ser ricos em açúcar, gorduras trans e sal.

Eles incluem alimentos como batatas fritas, doces, macarrão instantâneo, pipoca de microondas, molhos comprados em lojas e refeições prontas.

Esses alimentos geralmente são ricos em calorias e pobres em outros nutrientes. Eles são exatamente os tipos de alimentos que causam ganho de peso, o que pode ter um efeito negativo na saúde do cérebro.

Um estudo com 243 pessoas descobriu que o aumento da gordura ao redor dos órgãos, ou gordura visceral, está associado a danos no tecido cerebral. Outro estudo com 130 pessoas descobriu que há uma diminuição mensurável no tecido cerebral, mesmo nos estágios iniciais da síndrome metabólica.

A composição de nutrientes dos alimentos processados na dieta ocidental também pode afetar negativamente o cérebro e contribuir para o desenvolvimento de doenças degenerativas.

Você pode evitar alimentos processados comendo principalmente alimentos frescos e inteiros, como frutas, vegetais, nozes, sementes, legumes, carne e peixe. Além disso, foi demonstrado que uma dieta de estilo mediterrâneo protege contra o declínio cognitivo.

Aspartame

O aspartame é um adoçante artificial usado em muitos produtos sem açúcar.

As pessoas costumam usá-lo ao tentar perder peso ou evitar o açúcar quando têm diabetes. Também é encontrado em muitos produtos comerciais não direcionados especificamente para pessoas com diabetes.

No entanto, este adoçante amplamente utilizado também foi associado a problemas comportamentais e cognitivos.

O aspartame é feito de fenilalanina, metanol e ácido aspártico. Essas substâncias, ao serem quebradas pelo organismo, produzem uma química que é conhecida por gerar tumores no cérebro.

O metanol, que é encontrado em grandes quantidades nos refrigerantes diet, é uma das químicas perigosas. Bastam 30 °C para que o metanol seja transformado em formol e ácido fórmico, que são neurotoxinas que provocam a morte celular e causam danos neurológicos.

O ácido aspártico contém excitotoxinas, que são neurotransmissores no cérebro e, quando consumido em grandes quantidades, se tornam hiper-excitadas, disparando as células nervosas.

Também há a fenilalanina, que deve ser indicada nos rótulos dos produtos, pois a ingestão excessiva deste aminoácido pode ser prejudicial em indivíduos com fenilcetonúria. Tontura, fraqueza, dormências e problemas de visão podem sinalizar envenenamento por consumo constante e em longo prazo de aspartame.

Apesar dessas descobertas, o aspartame ainda é considerado um adoçante seguro em geral se as pessoas o consumirem em cerca de 18-23 mg por libra (40-50 mg por kg) de peso corporal por dia ou menos.

No entanto, se você preferir evitá-lo, pode simplesmente cortar os adoçantes artificiais e o excesso de açúcar de sua dieta.

Álcool

Quando consumido com moderação, o álcool pode ser uma soma agradável a uma boa refeição. No entanto, seu consumo excessivo pode gerar efeitos graves no cérebro.

O uso crônico de álcool resulta em redução do volume cerebral, alterações metabólicas e interrupção dos neurotransmissores, que são as substâncias químicas que o cérebro usa para se comunicar.

Pessoas com alcoolismo geralmente têm deficiência de vitamina B1. Isso pode levar a um distúrbio cerebral que inclui perda de memória, distúrbios na visão, confusão e instabilidade.

Um efeito adicional do álcool é a interrupção dos padrões de sono. Beber grandes quantidades de álcool antes de dormir está associado à má qualidade do sono, o que pode levar à privação crônica do sono.

No entanto, o consumo moderado de álcool pode ter efeitos benéficos, incluindo melhora da saúde cardíaca e redução do risco de diabetes. Esses efeitos benéficos foram observados principalmente no consumo moderado de vinho de uma taça por dia.

No geral, você deve evitar o consumo excessivo de álcool, especialmente se você for um adolescente ou jovem adulto. Se você estiver grávida, é mais seguro evitar o consumo de álcool por completo.

Peixes ricos em mercúrio

O mercúrio é um contaminante de metal pesado e veneno neurológico que pode ser armazenado por um longo tempo em tecidos animais.

O consumo de peixes e frutos do mar com alta concentração de mercúrio pode trazer problemas para os sistemas digestivo e imunológico, além de afetar pulmões, rins e olhos.

Os efeitos da toxicidade do mercúrio também incluem perturbação do sistema nervoso central e neurotransmissores e estimulação de neurotoxinas, causando em danos ao cérebro.

Peixes maiores e que ocupam a parte mais alta da cadeia alimentar são particularmente suscetíveis ao acúmulo de mercúrio e podem transportar quantidades mais de 1 milhão de vezes a concentração da água ao seu redor.

No entanto, a maioria dos peixes não é uma fonte significante de mercúrio. Na verdade, o peixe é uma proteína de alta qualidade e contém muitos nutrientes importantes, como ômega-3, vitamina B12, zinco, ferro e magnésio. Portanto, é importante incluir o peixe em uma dieta saudável.

Recomenda-se que os adultos comam duas a três porções de peixe por semana. No entanto, se você estiver comendo tubarão ou peixe-espada, consuma apenas uma porção e nenhum outro peixe naquela semana.

Além disso, se você estiver pescando seus próprios peixes, é uma boa ideia verificar com as autoridades locais os níveis de mercúrio na água de onde você está pescando.

Os 7 piores alimentos para o seu cérebro

Por Redação

físico austríaco Ludwig Eduard Boltzmann (1844-1906) entendeu que a função da filosofia na era científica é resolver os problemas mais gerais que surgem no estudo da natureza e, a partir de suas soluções, fornecer à ciência um arcabouço e um fundamento que permite que você resolva problemas específicos de forma eficiente. A filosofia, portanto, não pode ser uma atividade separada da ciência, mas deve ser retroalimentada com ela, deve mudar com ela e deve servir sempre para proporcionar uma melhor compreensão dos problemas científicos. Uma filosofia que cumpre essas funções pode ser chamada de “filosofia científica”. A visão de Boltzmann de uma filosofia científica – isto é, de uma filosofia que lida com problemas gerais comuns a todas as ciências, uma filosofia que é informada pela ciência e serve à investigação científica – começou a ser desenvolvida no século 20 por filósofos com forte formação científica, como Bertrand Russell (matemático e lógico), Moritz Schlick (físico), Hans Reichenbach (físico e lógico), Rudolf Carnap (lógico e semântico), Hans Hahn (matemático), Otto Neurath (sociólogo), Willard van Orman Quine (lógico), Mario Bunge (filósofo e físico) e Nicholas Rescher (filósofo) (ver, por exemplo, Bunge, 1974-1989; Reichenbach, 1977; Rescher, 2001; Ferrater-Mora, 1994).

filosofia científica hoje é representada por um grande número de filósofos profissionais com formação científica séria que lidam com problemas relacionados à física, biologia, matemática, ciências sociais e, também, questões gerais.

Novos problemas filosóficos aparecem com o avanço da ciência (por exemplo, antes das investigações de Albert Einstein e Hermann Minkowski, a problemática sobre a natureza do espaço-tempo não existia) e outros desaparecem (os avanços da neurociência tornaram problemas relacionados a substâncias mentais irrelevantes ou pior, mostraram ser pseudoproblemas). A filosofia científica evolui com a ciência e a ciência usa conceitos filosóficos.

Cada ciência específica pode ajudar a testar certas teorias filosóficas. Por exemplo, conjecturas filosóficas sobre a incidência de padrões de simetria visual na experiência estética podem ser avaliadas por meio de estudos não invasivos da atividade cerebral de indivíduos expostos a certas obras artísticas com padrões definidos, em experimentos com controles de erro adequados.

As ciências físicas, e em particular a astrofísica, podem ajudar a contrastar muitas ideias filosóficas no campo da ontologia. Vou agora discutir algumas dessas questões à luz da astrofísica atual.

A natureza da irreversibilidade

É fato que as coisas envelhecem, se rompem, apodrecem. Nós envelhecemos e morremos. Este fato é cientificamente expresso na segunda lei da termodinâmica. Esta lei pode ser interpretada de várias maneiras. Uma deles, segundo Boltzmann (1974), diz que qualquer operação física em um sistema “não ideal” resultará em um aumento em sua entropia. A entropia aumentará até seu valor máximo possível. Quando isso acontecer, o sistema estará em equilíbrio termodinâmico: não mudará mais. Não vai funcionar. Nada mais acontecerá. Em nosso caso, atingir o equilíbrio termodinâmico é morrer: quando nosso corpo atinge uma temperatura uniforme, e essa temperatura é a mesma da sala em que estamos, então essa sala conterá nosso cadáver.

O que é essa entropia que Boltzmann fala? Suponha que temos um sistema feito de muitos componentes, como um gás composto de muitos átomos, ou nosso corpo, composto de muitas células, ou o universo, feito de muitas galáxias. Cada um dos componentes pode estar, em princípio, em vários estados. Uma molécula, por exemplo, pode ter velocidades diferentes. Nem todos esses estados serão igualmente prováveis. Alguns são mais prováveis do que outros. Entropia é uma medida da distribuição de probabilidade dos estados do sistema. Se todos os componentes do sistema estão em seu estado mais provável, o sistema não muda mais (qualquer outra configuração seria menos provável) e a entropia é máxima. Chamamos esse estado de probabilidade máxima de “equilíbrio termodinâmico”.

Obviamente, o mundo não está em equilíbrio termodinâmico. Você leu este artigo, então algo deve estar mudando em seu cérebro. Seu quarto está cheio de sons e sua vida, de acontecimentos. Por que o mundo ainda não está em equilíbrio termodinâmico? Por que a entropia ainda não atingiu seu máximo? A resposta usual a essas perguntas é que o mundo, o sistema de todas as coisas, o que chamamos de “universo”, começou há um tempo finito e em um estado de menor entropia. Isso é chamado de “hipótese do passado”. É uma hipótese que parece óbvia, mas também insatisfatória. Por que essa condição inicial? Há filósofos que dizem que não faz sentido perguntar isso. Seria um “fato grosseiro”, algo que não pode ser explicado em termos de outros fatos, porque não há precedentes.

Confesso que não acredito em fatos grosseiros. Todos os fatos que conhecemos são “legais”: eles estão sujeitos a leis, padrões regulares de ocorrência de eventos. A ciência, em sua função fundamental, consiste em encontrar esses padrões regulares, que chamamos de “leis”, e expor os mecanismos (cadeias de processos legais) pelos quais diferentes eventos ocorrem. Dizer que um fato é “grosseiro” é admitir magia. É desistir do ideal científico. Acho que podemos fazer melhor do que se conformar. Boltzmann, por exemplo, não se conformou. Ele conjeturou que o universo, em geral, está em equilíbrio termodinâmico, mas aqui e ali, a cada incontáveis eras (se o tempo fizer sentido na ausência de mudança) ocorre uma flutuação estatística altamente improvável, mas não impossível. Então, uma parte do universo – que em geral está morto –, diminui sua entropia e alguns eventos (a história do mundo) ocorrem. É uma ideia bonita. Mas como Arthur Eddington mostrou na década de 1930, a probabilidade disso acontecer é incomparavelmente menor do que uma flutuação estatística surgir e você, leitor, com este artigo diante de sua pessoa, desaparecer após lê-lo. A explicação de por que a entropia aumenta deve ser mais sutil e complexa, sem dúvida, do que uma mera flutuação

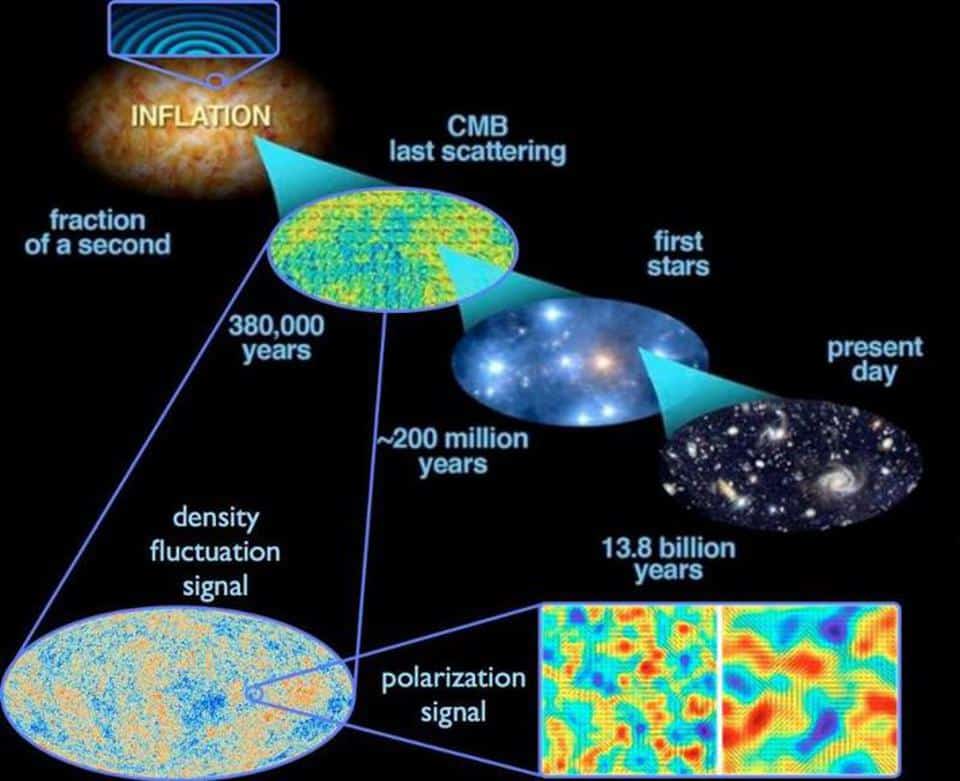

problema é agravado por descobertas recentes em astrofísica e cosmologia. As observações astronômicas mostram que o universo está se expandindo (na verdade, ele até parece estar se expandindo em uma taxa acelerada). Isso significa que no passado era mais denso e, portanto, mais quente do que agora. Quando a temperatura média do universo era de alguns milhares de graus, a matéria estava em um estado chamado “plasma”. Nesse estado, os elétrons são separados dos núcleos dos átomos. Cerca de 380.000 anos após o início do estágio de expansão do universo que observamos, a temperatura caiu abaixo do valor em que os átomos de hidrogênio permanecem ionizados (sem seu elétron). O resultado foi que os elétrons foram capturados pelos prótons, o hidrogênio neutro foi formado e os fótons, que até então eram absorvidos pelo plasma, conseguiram escapar. Hoje podemos observar aqueles fótons que constituem uma radiação universal que vem de todas as direções. Essa radiação é chamada de “radiação cósmica de fundo”. Ela foi medida com extrema precisão por satélites como COBE, WMAP e, recentemente, pelo satélite Planck da Agência Espacial Europeia. Essas medições mostram que a radiação produzida em todo o universo primitivo estava em perfeito equilíbrio térmico: o gás que a produzia tinha uma distribuição de partículas exatamente a mesma de um sistema com entropia máxima! Como é possível então que o mundo esteja desequilibrado hoje? Por que a entropia continua aumentando se está em seu valor mais alto possível?

A resposta a essas perguntas só pode ser que, na realidade, a entropia não estava realmente em seu máximo quando o universo se tornou transparente à sua própria radiação. Deve haver um componente de baixa entropia que não aparece em nossas observações. Ou, se aparece, não o estamos reconhecendo. Esse componente é a entropia da gravitação. O estado de equilíbrio de um sistema gravitacional é o colapso, uma vez que a gravidade é uma força atrativa. O colapso de um objeto significa que ele se tornará o mais compacto possível. No entanto, no início do universo, quando ocorreu a radiação cósmica de fundo, não havia praticamente nenhuma estrutura. Não havia estrelas, nem galáxias, nem aglomerados de galáxias. Apenas um gás extremamente homogêneo. A entropia associada à gravitação desse gás era extremamente baixa. À medida que o gás entrava em colapso e formava estrutura, a estrutura conhecida do universo, a entropia total, a da gravitação e a da matéria, aumentavam. E tem continuado a crescer até hoje.

Essa solução para o problema levanta duas novas questões: como é possível que a gravitação tenha entropia? E por que a entropia da gravitação era tão baixa 13,8 bilhões de anos atrás? A primeira questão admite apenas uma resposta: a gravitação deve ter uma estrutura interna. E essa estrutura interna é o que lhe dá os graus de liberdade necessários para definir a entropia. Não sabemos como é essa estrutura. Mas começamos a suspeitar e nossas conjecturas tentam ser articuladas em uma teoria quântica da gravitação, da qual tratarei mais tarde.

A segunda pergunta exige explicar as condições do universo há quase 14 bilhões de anos. Qual mecanismo poderia colocar o universo nesse estado, sem estrutura? Uma maneira de tornar homogêneo algo não homogêneo é comprimi-lo, reunir todos os componentes e, em seguida, expandi-lo isotropicamente. Isso poderia ter acontecido se o universo não teve começo há 13,8 bilhões de anos e o que na realidade aconteceu foi o início de uma fase de expansão após uma contração que destruiu a estrutura existente. Em outras palavras, o universo se contraiu, teve um “rebote” e ele se expandiu novamente. Ao fazer isso, ele regenerou a entropia de seu campo gravitacional. Certamente, isso requer condições muito específicas para o comportamento termodinâmico da gravidade em altas densidades (Novello e Perez-Bergliaffa, 2008). É possível testar cientificamente essas ideias? Surpreendentemente, a resposta é “sim”.

O rebote do universo implica o movimento de grandes massas, que geram ondas gravitacionais. Essas ondas são muito fracas para serem detectadas hoje. No entanto, elas deixaram sua marca na polarização da radiação cósmica de fundo. Estes são chamados de “modos-B de polarização”, que são caracterizados por um efeito de rotação das linhas de polarização. Esse efeito se deu pela distorções nas direções de oscilação das cargas elétricas que produziram radiação no universo primitivo. Esses modos-B de polarização, se existirem, podem ser detectados em um futuro próximo por telescópios submilimétricos (Stolpovskiy, 2016). A partir de medições da intensidade e da forma dessa polarização, modelos de rebote podem ser testados para o início da expansão do universo.

Tentei mostrar nesta seção que a astrofísica e a cosmologia contemporâneas contribuíram muito para resolver uma questão colocada pela filosofia científica: por que os processos do mundo são irreversíveis se a representação matemática de suas leis é reversível? A resposta é que o estado do mundo não é determinado apenas pelas leis, mas pelas leis e pelas condições iniciais em que as leis são aplicadas. Vivemos hoje à custa da baixa entropia do campo gravitacional. Em última análise, toda mudança é possível porque o campo gravitacional ainda não está em colapso. No início do universo, parece que existiam mecanismos naturais que permitiam à gravitação regenerar sua entropia. Estabelecer como isso aconteceu é mais uma questão mais científica do que filosófica (Romero e Pérez, 2011).

Espaço e tempo existem

Como se sabe, Gottfried W. Leibniz e Isaac Newton discutiram sobre a natureza do espaço e do tempo no século XVII. A polêmica se desenvolveu por meio da mediação de Samuel Clarke, que atuou como representante das ideias newtonianas. Leibniz argumentou que o espaço e o tempo não são entidades em si; isto é, eles não existem na ausência de objetos mutáveis. Para Leibniz, o espaço é apenas um sistema de relações espaciais entre objetos, e o tempo, uma relação entre objetos mutáveis. Se nada mudasse, pensou Leibniz, não haveria tempo. Se houvesse apenas uma coisa sem partes, não haveria espaço. Para Newton, por outro lado, espaço e tempo eram entidades reais, como mesas ou planetas. No entanto, ao contrário dos dois exemplos, espaço e tempo não são afetados por sua interação com outros objetos no Se o espaço não é uma entidade física como pensava Newton, o que é então? Leibniz responde: é um sistema de relações entre as coisas. Não há espaço como entidade existente e, sim, existem relações espaciais entre as entidades existentes. Se não houvesse coisas, não haveria espaço. Se não houvesse mudanças, não haveria tempo. Newton discordou. Para mostrar que o espaço é algo, ele propôs sua famosa experiência do balde de água preso ao teto por uma corda. Para isso, era necessário fazer o balde girar sozinho, torcendo a corda. Conforme você deixa o sistema livre, o balde começará a girar. No início, a água estará parada. Então, o balde irá transmitir seu movimento rotacional para a água por fricção e esta adquirirá momento angular. À medida que ele aumenta, a superfície da água se transforma em um paraboloide devido às forças centrífugas. Se pararmos o balde, a água continuará a girar e irá manter sua superfície parabólica até que o atrito a retorne ao repouso. Em relação a que a água é acelerada? Não pode ser em relação ao balde, já que a superfície é parabólica quando gira e quando não gira. Newton responde que a água deve acelerar em relação ao espaço absoluto. Portanto, o espaço absoluto é “algo”. Há uma entidade ontológica. Nada pode ser acelerado em relação ao que não existe.

Infelizmente, Leibniz morreu no meio do debate e nunca foi capaz de responder a esse argumento. Mas Ernst Mach respondeu no século XIX: ele afirmou que a água acelera em relação a “estrelas distantes”, isto é, em relação à média do resto da massa no universo. No século 20, Einstein acreditava que poderia explicar a natureza da inércia e o princípio de Mach por meio de sua teoria geral da relatividade. Einstein mostrou que a gravitação e a inércia são dois aspectos do mesmo campo gravito-inercial e acreditava que sua teoria não poderia admitir soluções onde não existissem objetos materiais. Ele pensava que o espaço e o tempo não poderiam existir sem matéria.

Em 1917, o astrônomo holandês Willem de Sitter obteve uma solução dinâmica das equações de Einstein que representa um universo sem matéria, mas com espaço e tempo. No início, Einstein ficou cético, mas depois acabou admitindo que sua teoria não poderia explicar o princípio de Mach. Pior ainda, sua teoria representou o campo gravito-inercial com um campo métrico, que é usado para determinar distâncias em um objeto quadridimensional chamado “espaço-tempo”. O espaço-tempo é o sistema de todos os eventos. Tudo o que aconteceu, acontece ou vai acontecer faz parte desse sistema. O que chamamos de espaço nada mais é do que partes dessa entidade ao longo de uma dimensão que chamamos de tempo. O espaço-tempo, como um todo, entretanto, não muda e não pode mudar; não há algo possa fazer mudar: incluindo o tempo (Romero, 2012; 2013a; 2013b).

.

Leibniz desenvolveu um argumento engenhoso contra Newton baseado em seu princípio da identidade dos indiscerníveis (se dois supostos objetos são idênticos em todos os aspectos, incluindo os relacionais, então eles são o mesmo objeto). O argumento é o seguinte: imagine dois universos compostos exatamente pelos mesmos objetos relacionados da mesma maneira, mas localizados em posições diferentes no espaço. Se o espaço é uma coisa, as relações desses objetos com o espaço serão diferentes e os dois universos serão diferentes. No entanto, não há nenhuma propriedade do conjunto espaço + objetos que nos permita diferenciar entre os dois universos. Portanto, pelo princípio da identidade dos indiscerníveis, os dois universos são iguais. Como os universos não podem ser iguais e ao mesmo tempo diferentes, uma das hipóteses deve ser rejeitada: 1) O espaço é uma coisa; ou 2) O princípio da identidade dos indiscerníveis. Leibniz pensava que temos motivos para afirmar a segunda hipótese, então a primeira é falsa.

espaço-tempo é uma entidade? Realmente existe? Essas questões parecem ser de natureza puramente filosófica, mas podemos vislumbrar argumentos sobre elas com base na astrofísica contemporânea.

Os buracos negros há muito tempo deixaram de ser objetos exóticos cuja existência é prevista com base na teoria da relatividade geral e se tornaram uma parte essencial de nossa descrição do universo. O que são esses buracos negros que parecem tão abundantes no universo? Eles são o que resta de sistemas físicos (estrelas, nuvens de matéria escura) que entraram em colapso sob seu próprio campo gravitacional. A gravidade é essencialmente uma força atrativa em pequenas escalas. Quando um objeto é muito massivo, a atração gravitacional de sua própria matéria tende a torná-lo cada vez mais compacto. Se o sistema é estável, é porque alguma força interna se opõe à da gravitação. Essa força é o que gera a estrutura interna do sistema. Se o objeto for pesado o suficiente e a energia interna se exaurir, o objeto pode afundar com seu próprio peso. Ao fazer isso, ele arrasta o espaço-tempo com ele, que se curva de tal forma que todos os eventos dentro de uma determinada superfície se tornam indetectáveis do lado de fora. Essa superfície é chamada de “horizonte de eventos”. É uma região do espaço-tempo que o divide em duas partes, o interior ou “buraco negro” e o exterior ou “resto do universo”, onde existimos. O buraco negro, então, é feito de espaço-tempo, curvado de tal forma que o interior não pode entrar em contato com o exterior.

O horizonte de eventos não é algo diferente de uma região do espaço-tempo. No entanto, possui propriedades físicas definidas. Em particular, pode ser atribuída uma temperatura e uma entropia. Na verdade, quando algo cai no buraco negro – quando algo cruza seu horizonte de eventos – a entropia do horizonte aumenta. Podemos então propor os seguintes argumentos para mostrar a realidade do espaço-tempo (Romero, 2015b):

P1. Apenas entidades existentes podem ser aquecidas.

P2. O espaço-tempo pode ficar quente.

Portanto, o espaço-tempo é uma entidade existente.

A premissa P1 é verdadeira. O aquecimento está transmitindo calor para um sistema físico. Isso aumenta a temperatura do sistema. Esta operação só pode ser executada em sistemas físicos e não em ficções ou relacionamentos entre sistemas físicos. P2 também é verdadeiro à luz da física relativística: o horizonte de eventos de um buraco negro tem uma temperatura que muda quando algo cai nele. Se podemos aquecer o horizonte de eventos, é porque o que está aquecendo é o espaço-tempo. Então esse espaço-tempo existe.

Alternativamente:

P1. O espaço-tempo tem entropia.

P2. Só o que tem microestrutura tem entropia.

Portanto, o espaço-tempo tem uma microestrutura.

P3. Só o que existe tem microestrutura.

Portanto, o espaço-tempo existe.

P1 é verdadeiro porque o horizonte de eventos dos buracos negros é uma região de entropia do espaço-tempo. A entropia mede o número de microestados acessíveis a um sistema macroscópico e daí segue que a entropia só pode ser atribuída a sistemas físicos com microestrutura. Disto se segue que o espaço-tempo é uma entidade existente e não um mero sistema de relacionamentos.

Assim, vemos que a existência de buracos negros tem consequências filosóficas importantes para antigas disputas metafísicas. A astrofísica, ao investigar os aspectos mais extremos da realidade, pode ser usada para testar ideias ontológicas.

A dimensionalidade do mundo

Quantas dimensões tem o mundo? Filósofos “presentistas” sustentam que três: as três dimensões do espaço. E o tempo? Esses filósofos pensam que só existe o momento presente: nem o passado nem o futuro têm existência real. O passado já foi, podemos lembrar, mas não existe mais. O futuro ainda não aconteceu e, portanto, não existe. Apenas “há” o momento presente; e um momento não constitui uma dimensão (conjunto infinito de pontos), mas um único ponto. Esta visão filosófica, semelhante ao senso comum, é correta? Afirmo que não.

A teoria da relatividade especial, com sua relatividade bem corroborada da simultaneidade de eventos, é prova disso. Não existe “um” momento presente para todos os sistemas que constituem o universo. Eventos que podem parecer presentes e simultâneos para um observador são sucessivos para outro. Se a existência não depende do sistema de referência usado para descrever o mundo (princípio da objetividade), então não é possível afirmar que “apenas o presente existe”. A relatividade geral, entretanto, nos deu evidências ainda maiores para pensar que o passado e o futuro são tão reais quanto o presente e que as dimensões do mundo são quatro e não três. Ou seja, o tempo é uma dimensão tão válida quanto as espaciais e tão real quanto elas. A criança que fui é uma parte temporária do meu ser, como será a velha que serei (ou talvez eu já seja essa parte). Elas são partes diferentes de um objeto quadridimensional, tão diferentes quanto a minha mão é diferente da minha cabeça quando pensamos em apenas três dimensões espaciais.

Recentemente, a colaboração LIGO (do inglês Laser Interferometer Gravitational-Wave Observatory) relatou a detecção direta, pela primeira vez, de ondas gravitacionais. O anúncio, feito em fevereiro de 2016, refere-se a um evento registado em 14 de setembro de 2015 e que foi identificado com o código GW 150914. As ondas gravitacionais detectadas foram produzidas pela fusão de dois buracos negros com massas individuais de 36 ± 5 vezes e 29 ± 4 vezes a massa do Sol, o que resultou em um buraco negro de 62 ± 4 massas solares. Os 3,0 ± 0,5 massas solares restantes correspondem à energia emitida na forma de ondas gravitacionais. Como o evento ocorreu a uma distância de cerca de 400 megaparsecs,1 as ondas viajam pelo espaço há cerca de 1,3 bilhão de anos. Um segundo evento foi detectado em 26 de dezembro de 2015. Este sinal, produzido por um sistema menos massivo, foi anunciado em 15 de junho de 2016.

Essas detecções têm implicações importantes: mostram que a teoria da relatividade geral está correta em suas previsões de campos gravitacionais fortes dentro da sensibilidade dos instrumentos, removem qualquer dúvida sobre a existência de ondas gravitacionais e fornecem novas evidências para a existência de buracos negros. Também podem servir para mostrar que o presentismo, a doutrina filosófica que afirma que só o presente existe, é falso (para uma discussão sobre o assunto, ver Romero, 2015a). Vamos considerar o seguinte argumento (Romero, 2015b):

P1. Existem ondas gravitacionais.

P2. As ondas gravitacionais têm curvatura de Weyl diferente de zero.

P3. A curvatura de Weyl diferente de zero só é possível em quatro ou mais dimensões.

P4. O presentismo é incompatível com um mundo quadridimensional.

Portanto, o presentismo é falso.

As premissas P2 e P3 são necessariamente verdadeiras. As ondas gravitacionais se propagam no espaço vazio, onde as equações de campo de Einstein implicam que os componentes da gravitação associados à matéria são identicamente zero no vácuo. Mas a curvatura total do espaço-tempo não engloba apenas esse tipo de curvatura, chamada de curvatura de Ricci, mas também a curvatura associada ao próprio campo gravitacional, chamada de curvatura de Weyl, que é representada por meio do objeto matemático conhecido como “tensor de Weyl”. Portanto, como as ondas gravitacionais são alterações na curvatura do espaço-tempo, o tensor de Weyl deve ser diferente de zero em sua presença. Se as dimensões do mundo fossem três, como proposto pelos presentistas, o tensor de Weyl deveria ser zero. Apenas em quatro ou mais dimensões a gravidade pode se propagar no espaço-tempo vazio (Romero e Vila, 2014). Portanto, o presentista deve negar que o presentismo é incompatível com um mundo quadridimensional ou aceitar que o presentismo é falso. Mas o presentismo é essencialmente a doutrina de que as coisas não têm partes temporais. Qualquer admissão de extensão temporária é equivalente a desistir da afirmação básica do presentismo: não há futuro ou passado. Minha conclusão é que, uma vez que existem ondas gravitacionais, o presentimo é totalmente falso.

Mais uma vez, vemos como as observações astronômicas baseadas em considerações físicas podem servir para testar as doutrinas filosóficas. Quanto mais próximas da ciência estão as teorias filosóficas, mais factível é estabelecer sua plausibilidade. Da mesma forma, quanto mais informada a ciência dos problemas filosóficos, mais claras e diretas serão suas contribuições para o nosso conhecimento do mundo. Nesse círculo virtuoso, talvez a esperança de Boltzmann resida em que algum dia venhamos a pensar filosoficamente sobre todos os problemas científicos e a responder cientificamente a todos os problemas filosóficos.

1. 11 megaparsec (Mpc) equivale a mais de três milhões de anos-luz.

Referências

início do Universo nunca existiu? Mas… então quem nos enganou?

A humanidade olha para o espaço e precisa compreender como foi o início de tudo. Vivemos num Universo que não conhecemos nem sabemos onde começa e onde acaba. A única esperança que tínhamos era de recolher indícios de como foi que tudo começou. Mas… e se afinal nunca começou?

Sim, talvez não tenha havido começo. Talvez o nosso universo sempre tenha existido. Pelo menos é que nos vem dizer agora uma nova teoria da gravidade quântica.

Universo: Então não houve o Big Bang?

Bruno Bento, um físico português que estuda a natureza do tempo na Universidade de Liverpool, no Reino Unido, empregou uma nova teoria da gravidade quântica. Esta abordagem foi chamada de teoria do conjunto causal, na qual o espaço e o tempo são divididos em pedaços discretos de espaço-tempo.

A algum nível, existe uma unidade fundamental de espaço-tempo, de acordo com esta teoria.

A realidade tem tantas coisas que a maioria das pessoas associaria à ficção científica ou mesmo à fantasia.

Explicou Bruno Bento.

O físico e os seus colaboradores utilizaram esta abordagem causal para explorar o início do Universo. A equipa descobriu que é possível que o Universo não tenha tido início – que tenha sempre existido no passado infinito e só recentemente evoluiu para o que chamamos o Big Bang.

Singularidades: só sabemos que nada sabemos

A gravidade quântica é talvez o problema mais frustrante que a física moderna enfrenta. Existem duas teorias extraordinariamente eficazes sobre o universo: a física quântica e a relatividade geral.

A física quântica produziu uma descrição bem sucedida de três das quatro forças fundamentais da natureza (o eletromagnetismo, a força fraca e a força forte) até escalas microscópicas. A relatividade geral, por outro lado, é a descrição mais poderosa e completa da gravidade jamais concebida.

Contudo, apesar de ter os seus pontos fortes, a relatividade geral é incompleta. Em pelo menos dois lugares específicos do universo, a matemática da relatividade geral simplesmente decompõe-se, não produzindo resultados fiáveis: nos centros dos buracos negros e no início do universo.

Estas regiões são chamadas “singularidades”, que são pontos no espaço-tempo onde as nossas leis atuais da física se desmoronam, e são sinais matemáticos de alerta de que a teoria da relatividade geral está a tropeçar em si mesma. Dentro destas duas singularidades, a gravidade torna-se incrivelmente forte a escalas de comprimento muito pequenas.

Assim, para resolver os mistérios das singularidades, os físicos precisam de uma descrição microscópica da forte gravidade, também chamada teoria quântica da gravidade. Há muitas ideias concorrentes por aí, incluindo a teoria das cordas e a gravidade quântica em loop

E há outra abordagem que reescreve completamente a nossa compreensão do espaço e do tempo.

Teoria do conjunto causal

Em todas as teorias atuais da física, o espaço e o tempo são contínuos. Eles formam um tecido liso que sustenta toda a realidade. No tal espaço-tempo contínuo, dois pontos podem estar o mais próximos possível um do outro no espaço, e dois eventos podem ocorrer o mais próximos possível no tempo.

Mas outra abordagem, chamada teoria dos conjuntos causais, reimagina o espaço-tempo como uma série de pedaços discretos, ou “átomos” de espaço-tempo. Esta teoria colocaria limites estritos sobre o quão próximos os eventos podem estar no espaço e no tempo, uma vez que eles não podem estar mais próximos do que o tamanho do “átomo”.

Por exemplo, se estiver a olhar para o seu ecrã a ler isto, tudo parece suave e contínuo. Mas se olhar para o mesmo ecrã através de uma lupa, poderá ver os pixels que dividem o espaço, e descobrirá que é impossível aproximar duas imagens no seu ecrã mais do que um único pixel.

Fiquei emocionado quando encontrei esta teoria, que não tenta apenas ser o mais fundamental possível — apresentando-se como uma abordagem à gravidade quântica que repensa a noção do espaço-tempo — mas que também dá um papel central ao tempo e ao que significa a sua passagem.

Explicou o investigador à revista Live Science.

O Universo e o início dos tempos

A teoria do conjunto causal tem implicações importantes para a natureza do tempo.

Uma grande parte da filosofia do conjunto causal é que a passagem do tempo é algo físico, que não deve ser atribuído a algum tipo de ilusão emergente ou a algo que acontece dentro do nosso cérebro que nos faz pensar que o tempo passa; esta passagem é, em si mesma, uma manifestação da teoria física.

Assim, na teoria do conjunto causal, um conjunto causal irá crescer um ‘átomo’ de cada vez e tornar-se cada vez maior.

Disse Bento.

Portanto, sem uma singularidade do Big Bang, como é o início do nosso universo? Foi aí que Bento e o seu colaborador, Stav Zalel, aluno de pós-graduação do Imperial College London, pegaram no fio da meada, explorando o que a teoria do conjunto causal tem a dizer sobre os momentos iniciais do universo.

O seu trabalho aparece num artigo publicado a 24 de setembro na base de dados de pré-impressão arXiv. (O artigo tem ainda de ser publicado numa revista científica revista por pares).

Há agora uma densa linha de estudo. Conforme referem os investigadores, há ainda muito trabalho para ser feito.

De muitas maneiras, nossas observações do Universo distante são as coisas mais próximas que chegaremos de ter uma máquina do tempo. Embora não possamos viajar no tempo, podemos fazer a segunda melhor coisa: ver o Universo não como ele é hoje, mas como era há muito tempo atrás. Sempre que a luz é emitida de uma fonte distante – como uma estrela, galáxia ou quasar – ela primeiro precisa atravessar as vastas distâncias cósmicas que separam essa fonte de nós mesmos, o observador, e isso leva tempo.

Mesmo na velocidade da luz, pode levar bilhões ou mesmo mais de dez bilhões de anos para esses sinais chegarem, o que significa que quanto mais longe vemos um objeto distante, mais perto do Big Bang estamos olhando. A primeira luz que podemos ver, no entanto, vem de uma época anterior a qualquer estrela ou galáxia: quando os núcleos atômicos e os elétrons do Universo se combinavam para formar átomos neutros. De maneira incrível, esta é apenas uma peculiaridade muito específica da física quântica que nos permite ver o Universo como ele era há muito tempo. Sem ela, os primeiros sinais não existiriam e seríamos incapazes de olhar para trás no tempo e a fundo no espaço como podemos hoje. Veja como a física quântica nos permite ver tão longe no espaço e no tempo.

Para entender de onde vem o primeiro sinal observável no Universo, temos que voltar no tempo: aos primeiros instantes do Big Bang. Na época em que o Universo era quente, denso, quase perfeitamente uniforme e cheio de uma mistura de matéria, antimatéria e radiação, ele estava se expandindo com uma rapidez incrível. Nesses primeiros momentos, havia regiões do Universo que eram ligeiramente mais densas que a média e regiões que eram um pouco menos densas que a média, mas apenas cerca de 1 parte em 30.000.

Se dependesse apenas da gravidade, as regiões superdensas cresceriam, atraindo mais matéria circundante do que regiões normais ou subdensas, enquanto as regiões subdensas cederiam sua matéria às regiões circundantes, mais densas. Mas o Universo não é governado apenas pela gravidade; as outras forças da natureza desempenham um papel importante. A radiação, por exemplo – particularmente na forma de fótons – é extremamente energética no início do Universo, e seus efeitos sobre como a matéria evolui são importantes de várias maneiras

matéria evolui são importantes de várias maneiras.

Em primeiro lugar, a matéria (e a antimatéria), se for eletricamente carregada, se espalhará rapidamente pelos fótons. Isso significa que qualquer quantum de radiação, a qualquer momento que encontrar uma partícula carregada, irá interagir e trocar energia com ela, com encontros sendo mais prováveis com partículas carregadas de baixa massa (como elétrons) do que com alta massa (como prótons ou núcleos atômicos).

Em segundo lugar, conforme a matéria tenta entrar em colapso gravitacional, a densidade de energia daquela região sobe acima desta média. Mas a radiação responde a essas densidades de energia mais altas fluindo dessas regiões de alta densidade para as de densidade mais baixa, e isso leva a uma espécie de “salto”, onde:

- densidades aumentam,

- a pressão do fóton aumenta,

- fótons fluem para fora,

- a densidade cai,

- fazendo com que a pressão do fóton caia,

- fazendo com que fótons e matéria fluam de volta,

- aumentando a densidade,

e o ciclo continua. Quando falamos sobre as flutuações que vemos na radiação cósmica de fundo, elas seguem um padrão particular de “balanços” que corresponde a esses “saltos”, ou oscilações acústicas, ocorrendo no plasma do Universo primitivo.

ocorrendo no plasma do Universo primitivo.

Mas há uma terceira coisa acontecendo simultaneamente com tudo isso: o Universo está se expandindo. Quando o Universo se expande, sua densidade diminui, pois o número total de partículas dentro dele permanece o mesmo enquanto o volume aumenta. Uma segunda coisa, no entanto, também acontece: o comprimento de onda de cada fóton – cada quantum de radiação eletromagnética – se estende à medida que o Universo se expande. Como o comprimento de onda de um fóton determina sua energia, com comprimentos de onda mais longos correspondendo a energias mais baixas, o Universo também esfria à medida que se expande.

Um Universo que fica menos denso e esfria de um estado inicialmente quente e denso fará muito mais do que apenas gravitar. Em altas energias, cada colisão entre dois quanta terá uma chance de criar espontaneamente pares de partícula/antipartícula; contanto que haja energia suficiente disponível em cada colisão para criar partículas massivas (e antipartículas) via o conceito de E = mc² de Einstein, há uma chance de que isso aconteça.

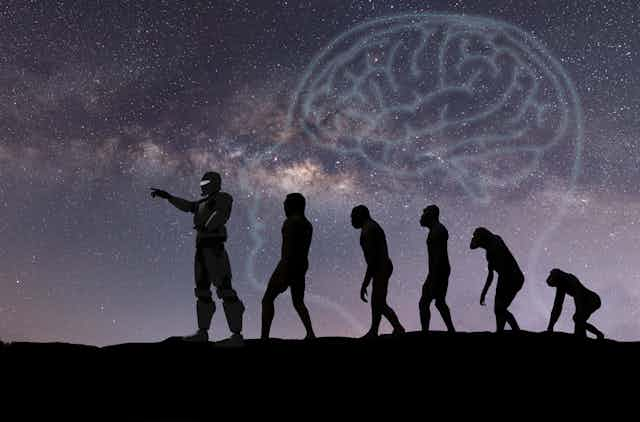

Apenas 7 % do nosso DNA é exclusivo de humanos modernos, diz estudo

Pesquisa analisou DNA de restos fósseis de neandertais e denisovanos extintos, bem como de 279 pessoas modernas de todo o mundo

“Esse tipo de descoberta é o motivo pelo qual os cientistas estão deixando de pensar que nós, humanos, somos tão diferentes dos Neandertais.". É assim que o cientista Nathan Schaefer, biólogo computacional da Universidade da Califórnia, resume a relevância de um artigo recém publicado na pesquisa ainda destaca que uma fração ainda menor de nosso genoma, apenas 1,5%, é exclusiva de nossa espécie e de fato compartilhada entre todas as pessoas vivas hoje. Pequenas partes de DNA que podem carregar as pistas mais significativas sobre o que realmente distingue os seres humanos modernos.

Segundo Green, co-autor do novo artigo, que em 2010 ajudou a produzir o primeiro esboço de sequência de um genoma de Neandertal: "Podemos dizer que essas regiões do genoma são altamente enriquecidas por genes que têm a ver com o desenvolvimento neural e a função cerebral". Science Advances. O estudo, assinado por Schafer, Beth Shapiro e Richard E. Green, afirma que apenas 7% do análise publicada agora baseia-se no DNA extraído de restos fósseis de neandertais e denisovanos extintos que datam de cerca de 40.000 ou 50.000 anos atrás, bem como de 279 pessoas modernas de todo o mundo.

Os cientistas já sabiam que as pessoas modernas compartilham parte do DNA com os neandertais, mas afirmam que, em geral, pessoas diferentes compartilham partes diferentes do genoma. Um dos objetivos da nova pesquisa era, portanto, identificar os genes exclusivos dos humanos modernos.

genoma é compartilhado exclusivamente com outros humanos, e não por nossos ancestrais primitivos.

Possivelmente a equação mais conhecida do mundo da Física, a “E = m.c²”, postulada por Albert Einstein em 1905, serviu de base para cientistas criarem matéria a partir da luz, em um estudo publicado no Physical Review Letters. A fórmula rege que a energia é igual à massa multiplicada pela velocidade da luz ao quadrado

equação de Einstein diz que duas partículas de luz (fótons) suficientemente carregadas, quando arremessadas uma contra a outra, podem criar matéria na forma de um elétron e um pósitron — partículas com carga negativa e positiva, respectivamente. Foi o que os cientistas do laboratório Brookhaven, nos EUA, fizeram.

Leia também

- Hubble registra fenômeno previsto por Einstein há mais de 100 anos

- Clarões ecoando por trás de buraco negro confirmam teoria de Einstein

- Física brasileira recebe o mesmo título de Albert Einstein e Charles Darwin

Esse processo, porém, é extremamente difícil de ser realizado. Os fótons obrigatoriamente devem ser raios gama muito energizados — o tipo de coisa que nós ainda não somos capazes de criar. Uma alternativa a isso foi proposta em 1934 pelos físicos Gregory Breit e John Wheeler, sugerindo o uso de íons. Foi o que os cientistas fizeram.

Uma das primeiras coisas que aprendemos nas aulas de ciência é que nada pode viajar mais rápido do que a velocidade da luz. Essa é uma regra fundamental proposta por Albert Einstein em sua Teoria da Relatividade. Mas os físicos acreditam agora que pelo menos uma coisa pode quebrar esta regra, ou pelo menos parece quebrar – o próprio universo. Os astrônomos acreditam que há galáxias se afastando da nossa a uma velocidade maior que a velocidade da luz. Como resultado, provavelmente nunca conseguiremos vê-las.

Foguete que viaje a 99% da velocidade da luz é teoricamente possível, diz professor

Há 13,78 bilhões de anos, nosso universo, que se concentrava em um ponto muito pequeno e denso, explodiu em um evento que chamamos de Big Bang. Após a explosão, o universo expandiu a uma taxa de 10¹⁶ em uma fração de segundo, durante um período de inflação que ocorreu a uma velocidade maior que a da luz. Depois disso, seria de se imaginar que o universo se expandiria a uma taxa constante ou mesmo diminuiria sua velocidade. Se a velocidade diminuísse, poderíamos ver até o limite, pois não haveria nenhum lugar que fosse muito longe para a luz viajar.

Em vez disso, a taxa de expansão do universo tem acelerado. E há lugares no universo que estão tão distantes que os fótons nunca chegarão lá. Como resultado, as bordas do nosso cosmos permanecem na sombra. O que está além delas é um mistério que talvez nunca possamos resolver.

Essa expansão ainda está ocorrendo, a uma taxa cada vez maior. E não é apenas a matéria, mas o tecido do próprio universo. Além disso, as Quando chegam a cerca de 4.200 megaparsecs de distância, as galáxias viajam mais rápido que a luz – só por curiosidade, 4.200 megaresecs é igual a 130.000.000.000.000.000.000.000 km. Os astrônomos conseguem calcular a que distância uma galáxia está pela distância que ela percorreu e pelo tempo necessário para percorrer essa distância, observando cuidadosamente a luz que vem dela.

Galáxias vermelhas

Podemos dizer a que distância uma galáxia se encontra por algo chamado desvio para o vermelho e pela mudança para o azul. Quando uma galáxia se afasta, a luz demora mais para chegar até nós. Todo esse espaço entre a galáxia e nós força o comprimento de onda da luz a se alongar, movendo-a em direção à parte vermelha do espectro. Isso é conhecido como desvio para o vermelho. Esses objetos que se afastam de nós parecem vermelhos enquanto aqueles que se movem em nossa direção, cujos comprimentos de onda encurtam, parecem azuis.

A coisa mais dis

tante que podemos detectar é o fundo cósmico de microondas (CMB), um resíduo do que sobrou do Big Bang. Criado há 13,7 bilhões de anos, ele agora se estende homogeneamente 46 bilhões de anos-luz de distância em todas as direções.

De Longe, nas profundezas do espaço, no entanto, a relatividade geral se aplica, mas a relatividade especial não, e isso faz com a luz não seja mais exatamente o parâmetro, à medida que a velocidade mais alta se torna menos certa. A implicação de um universo em constante aceleração é uma morte cósmica melancólica. Ao longo de bilhões de anos, acredita-se que as galáxias se expandirão tão longe umas das outras que os gases que se reúnem para formar estrelas não conseguirão se unir.

A luz de outras galáxias também não poderá nos alcançar. E sem novas estrelas se formando, elas não serão nada para substituir as que se esgotaram. Isso significa um desvanecimento lento de toda a luz no universo e, em seu lugar, um cosmo para sempre envolto em trevas geladas. O universo vai literalmente apagar, a menos que outras forças possam neutralizar esse fenômeno. [Big Think] com Paul Sutter, astrofísico da Universidade do Estado de Ohio, nos EUA, e cientista-chefe do Centro de Ciências COSI, a noção de que a velocidade da luz é a velocidade máxima para a matéria (ou para dados) vem da relatividade especial de Einstein. Mas isso é parte do que ele chama de “física local”. Pode e, de fato, deve ser aplicado às coisas próxima mais distantes parecem estar se movendo mais rápido do que as que estão mais perto de nós. Pode até haver algumas se movendo mais rápido que a luz – e se for esse o caso, dificilmente as detectaríamos.

A taxa de expansão universal é de 68 quilômetros por segundo por megaparsec. Um parsec é 3,26 milhões de anos-luz, enquanto um megaparsec contêm um milhão de parsecs. A cada parsec mais longe uma galáxia está da nossa, é preciso adicionar 68 km / s à sua velocidade.

Uma equipe internacional de astrônomos descobriu um dos maiores fenômenos já observados no centro da Via Láctea: duas “bolhas” gigantes emissoras de ondas de rádio, acima e abaixo da região central da nossa galáxia. Essa foi a primeira grande descoberta do telescópio sul-africano MeerKAT, inaugurado há pouco mais de um ano. Esses objetos se estendem por um total de 1.400 anos-luz, que correspondem a cerca de 5% da distância entre o Sistema Solar e o centro da galáxia.

Essas estruturas em forma de bolhas podem ser observadas porque, dentro delas, os elétrons se movem e produzem ondas de rádio à medida em que são acelerados por campos magnéticos. No estudo publicado na Nature nesta quarta-feira (11), os cientistas mostraram como esse fenômeno, que supera todas as outras estruturas de rádio do nosso centro galáctico, é provavelmente o resultado de uma perto do buraco negro supermassivo da Via Láctea (o Sagittarius A*), algo que teria acontecido há alguns milhões de anos, produzindo uma incrível energia.

Os pesquisadores acreditam que essa explosão foi causada justamente pelo Sagittarius A*, quando ele teria passado por um período de intenso consumo de matéria. Outra explicação seria um evento de “explosão estelar”, ou seja, a formação quase simultânea e a subsequente morte de cerca de 100 grandes estrelas.

explosão

Para Oliver Pfuhl, astrônomo do Observatório Europeu do Sul, em Garching, na Alemanha, tanto a explosão de estrelas quanto a atividade do buraco negro podem estar por trás das bolhas, e ambos os eventos poderiam reforçar um ao outro. Inclusive, os pesquisadores sabem de uma explosão estelar que ocorreu na região há cerca de 7 milhões de anos. "É intrigante relacionar as bolhas de rádio a esse evento de formação estelar", diz Pfuhl.

O Dr. Heywood, autor principal do estudo, disse que “o centro de nossa galáxia é relativamente calmo quando comparado a outras galáxias com buracos negros centrais muito ativos”. Mesmo assim, “o buraco negro central da Via Láctea pode se tornar incomumente ativo, explodindo à medida em que periodicamente devora aglomerados maciços de poeira e gás”. Ou seja, é possível que, em um desses períodos incomuns, o Sagittarius A* tenha desencadeado explosões enormes que resultaram nessas estruturas emissoras de ondas de rádio nunca vistas antes.

Pista para um outro mistério

Essa descoberta pode também resolver outro quebra-cabeças da Via Láctea: a origem dos elétrons necessários para gerar a emissão de rádio de intrigantes filamentos magnetizados — estruturas semelhantes a fios que não são vistas em nenhum outro lugar, exceto no centro galáctico. Não houve até agora uma explicação definitiva sobre sua origem desde que os filamentos foram descobertos, há 35 anos, mas agora há uma pista: é que "quase todos os mais de cem filamentos estão confinados pelas bolhas de rádio" descobertas, de acordo com o co-autor do estudo, Farhad Yusef-Zadeh, da Northwestern University.

As bolhas foram encontradas meio que por acaso. Os pesquisadores que trabalham com o radiotelescópio MeerKAT as descobriram quando criaram uma imagem do centro galáctico para comemorar a inauguração do observatório, e realizavam um “test drive” da instalação. O MeerKAT é um conjunto de 64 antenas de rádio, cada uma com 13,5 metros de diâmetro, localizado em um local remoto na província do Cabo Setentrional.

“Com essa descoberta inesperada, estamos testemunhando na Via Láctea uma nova manifestação de fluxos de matéria e energia em escala de galáxias, fundamentalmente governados pelo buraco negro central', declarou o co-autor Fernando Camilo, do observatório. A expectativa é que o novo estudo ajude a encontrarmos muito em breve novas respostas sobre os mistérios até então inexplicáveis da Via Láctea e seu buraco negro supermassivo.Ca

Comentários

Postar um comentário